在统计学中,线性回归(Linear regression)是利用称为线性回归方程的最小二乘函数对一个或多个自变量和因变量之间关系进行建模的一种回归分析。这种函数是一个或多个称为回归系数的模型参数的线性组合。只有一个自变量的情况称为简单回归,大于一个自变量情况的叫做多元回归。下面以简单线性回归为例,以机器学习的方法求解此问题。

问题设定

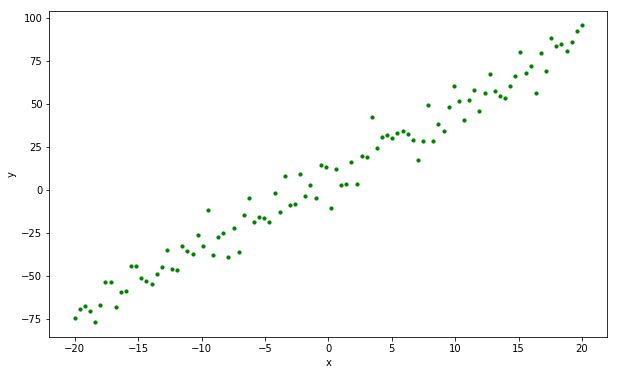

已知有 $N$ 个 $x, y$ 对构成数据集 $X, Y$ ,他们在坐标轴上的分布如下图:

现在希望找到一个函数:

$$h(x) = wx+b$$

这个函数会尽可能的拟合数据集 $X, Y$ ,为了做到这点,我们希望这个函数 $h(x)$ 在 $X$ 上每一个取值 $x_i$ 的函数值 $h(x_i)$ 与 $Y$ 上每一个对应的 $y_i$ 的平方差尽可能小。即找到一组 $w, b$ ,能使得 $loss(w, b)$ 最小。

$$loss(w, b) = \frac{1}{N}\sum^{N}_{i=0}(wx_i+b-y_i)^2$$

问题求解

采用梯度下降法找到目标 $w, b$,先随机初始化一对 $w_0, b_0$。由于函数的负梯度方向是函数值下降最快的方向,因此对 $w, b$ 求其偏微分:

$$\begin{aligned} \frac{\partial loss(w, b)}{\partial w} &= \frac{2}{N}\sum^{N}{i=0}(wx_i+b-y_i)\cdot x_i, \ \frac{\partial loss(w, b)}{\partial b} &= \frac{2}{N}\sum^{N}{i=0}(wx_i+b-y_i) \end{aligned}$$

再通过下式在每次迭代中更新 $w, b$ :

$$\begin{aligned} w_{t+1} &= w_t - \eta \frac{\partial l(w_t, b_t)}{\partial w_t} \ b_{t+1} &= b_t - \eta \frac{\partial l(w_t, b_t)}{\partial b_t} \end{aligned}$$

其中, $\eta$ 是学习率。

python实现

1 | # -*- coding: utf-8 -*- |

tensorflow实现

1 | # -*- coding: utf-8 -*- |

参考文献

- 线性回归, by wikipedia.

- 重拾基础 - 线性回归(一), by Cerulean.